PocketPal AI本地大模型v1.11.21 开源版

时间:2026-02-28 15:57

大小:138.6M

系统:Android

语言:中文

时间:2026-02-28 15:57

大小:138.6M

系统:Android

语言:中文

PocketPal AI本地大模型是一个手机上直接运行的本地AI对话工具,这个软件可以让你无需连接网络久等与其他的AI大模型进行聊天和交流,本地部署方法需要根据流程进行摸索,可以在本地增加一个最近十分热门的deepseek,这样就不会卡顿的进行使用了。

1.百度找到精品下载

2.在精品网中搜索PocketPal,点击下载

3.打开软件点击Models,点+,点Hugging Face搜索大模型

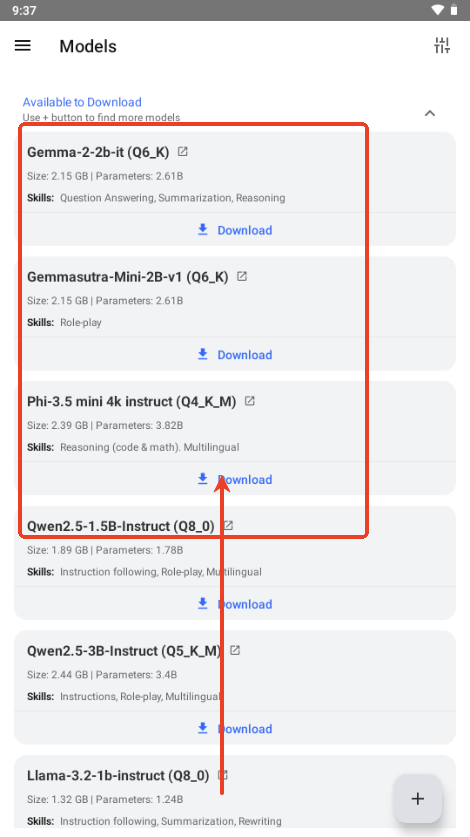

4.尽量下载名字带Q4_NL(4bit量化 normal 压缩)的模型,回答比较精准。

5.解释一下部分量化标识命名规则:NL 平衡精度与速度(Normal)、M 中等优化(middle)、 XS 极致压缩(Extra Small)、K 极限压缩(K-special)、Qx 量化位数(手机上运行 Q4 最佳)。

6.在加载好模型后在Settings中把N PREDICT设置为4096。

如果遇到问题请发到评论区,我会试着解决。

PocketPal AI 是一款袖珍型 AI 助手,由直接在手机上运行的小型语言模型 (SLM) 提供支持。PocketPal AI 专为 iOS 和 Android 设计,让您无需互联网连接即可与各种 SLM 进行交互。

离线 AI 协助:直接在您的设备上运行语言模型,无需互联网连接。

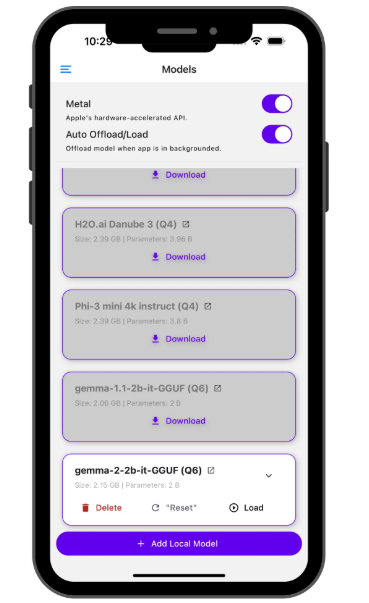

模型灵活性:下载并在多个 SLM 之间进行交换,包括 Danube 2 和 3、Phi、Gemma 2 和 Qwen。

Auto Offload/Load:当应用程序在后台运行时,通过卸载模型来自动管理内存。

推理设置:自定义模型参数,如系统提示符、温度、BOS 令牌和聊天模板。

实时性能指标:在 AI 响应生成期间查看每秒令牌数和每个令牌的毫秒数。

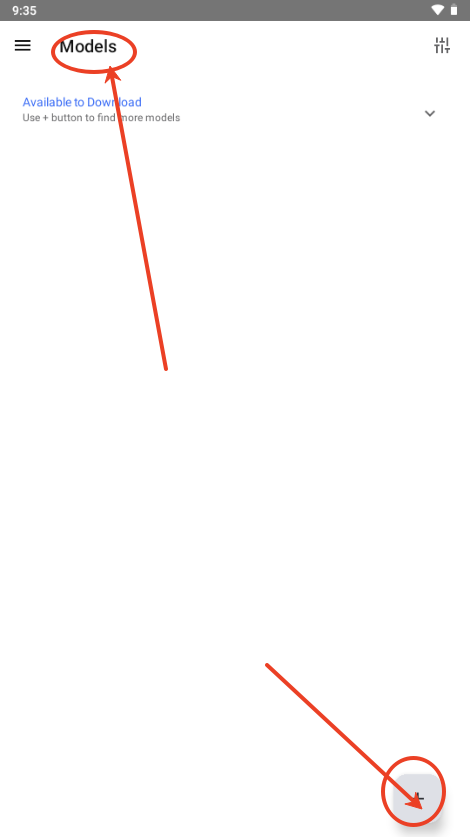

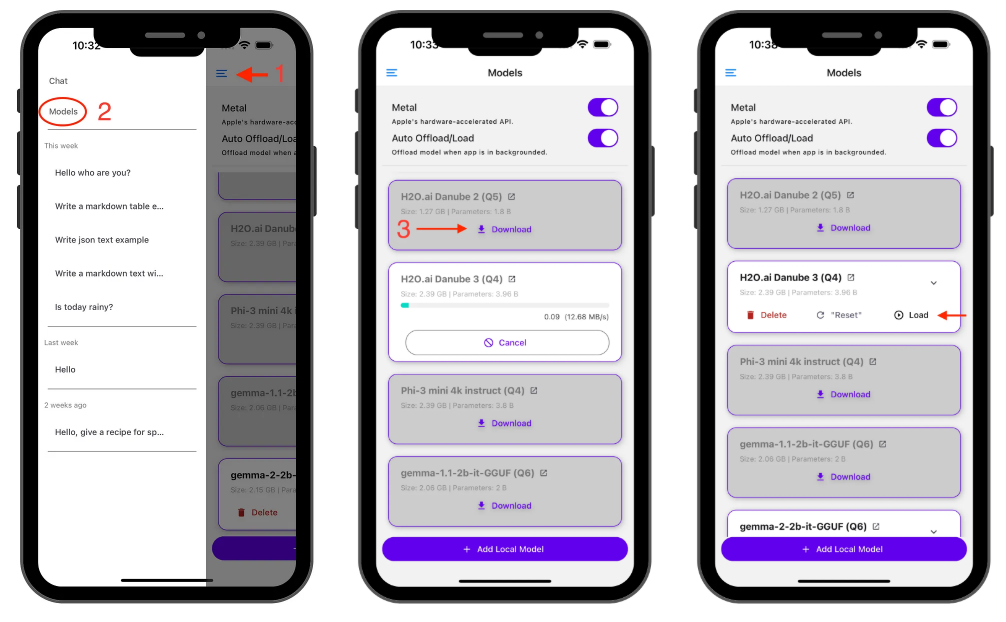

下载模型

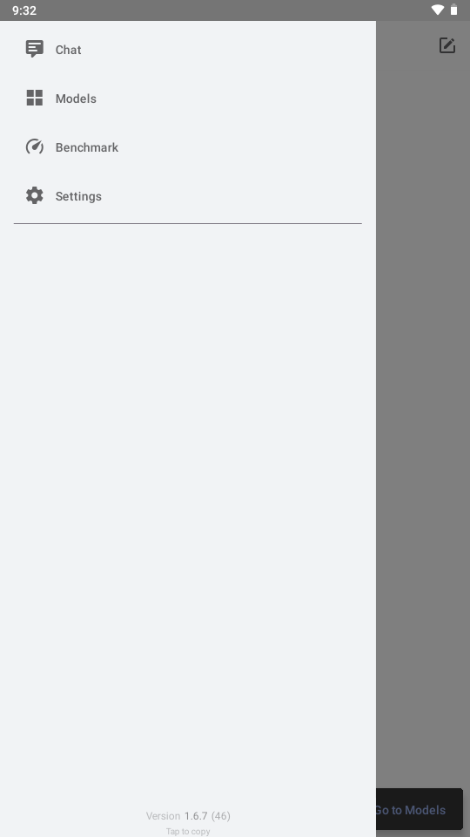

点击汉堡菜单

导航到 “Models” 页面

选择您想要的型号并点击下载

加载模型

下载后,点击 Load 将模型导入内存。现在您可以聊天了!

技巧

在 iOS 设备上,Apple 的 GPU API (Metal) 默认处于激活状态。如果您遇到任何问题,请尝试停用它。

iOS 金属

自动卸载/加载

为了保持设备平稳运行,PocketPal AI 可以自动管理内存使用情况:

在模型页面上启用 “Auto Offload/Load” (默认情况下是)

该应用程序将在后台卸载模型

当您返回时,它会重新加载(对于较大的模型,请等待几秒钟)

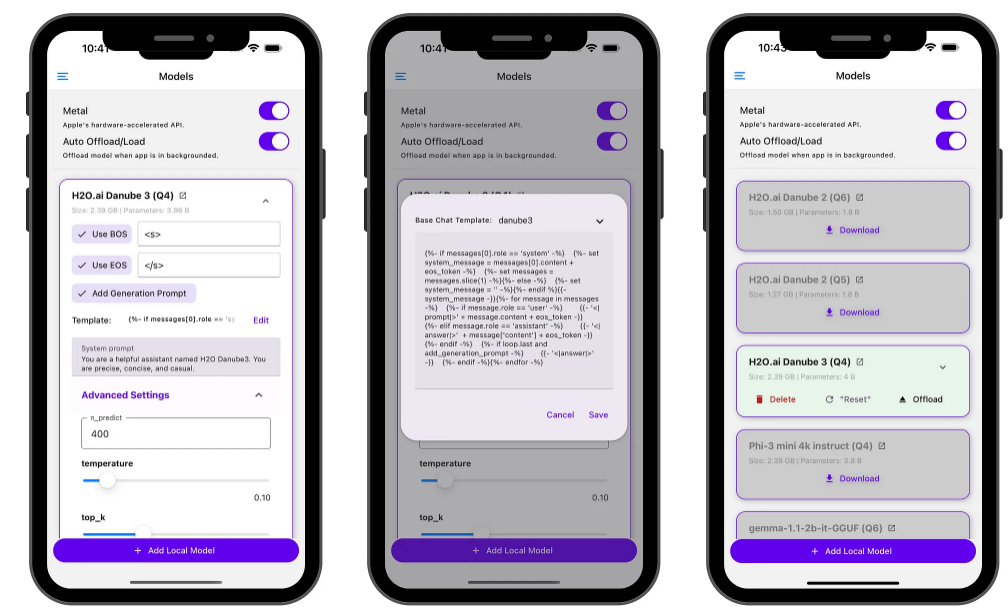

高级设置

单击 V 形图标可访问高级 LLM 设置,例如:

温度

BOS 代币

聊天模板选项

等。

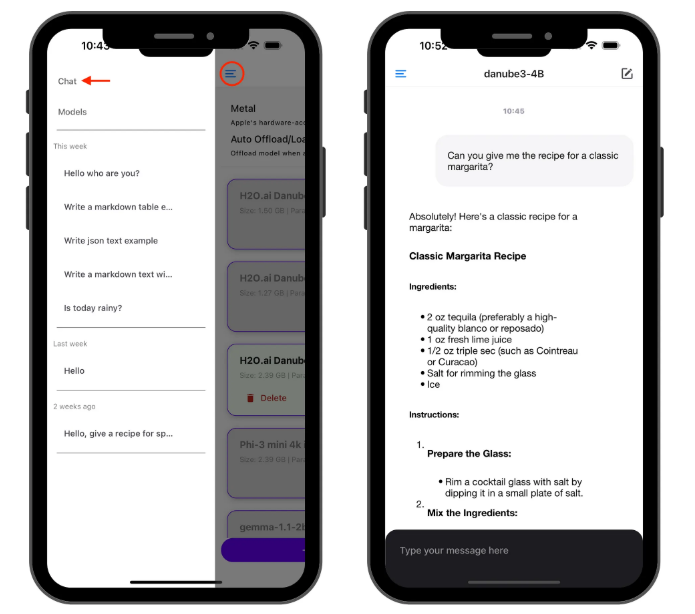

最后,让我们聊聊吧!

加载模型后,前往 “聊天” 页面并开始与加载的模型交谈!

此时还会显示 generation performance (生成性能) 指标。如果有兴趣,请观察聊天气泡以获取实时性能指标:每秒令牌数和每个令牌的毫秒数。

重要提示:截至目前,我还没有找到一种简单的方法来从生成的响应中选择和复制文本,同时保留文本格式,尤其是 Markdown 支持。

同时,以下是当前用于复制文本的选项:

段落级复制:长按特定段落可复制其内容。

完整响应复制:使用文本气泡底部的复制图标复制 AI 生成的整个响应。

我知道这些选项可能并不理想,这是我使用其他应用程序的挫败感之一。复制部分文本的困难曾经是 ChatGPT 等聊天应用程序特别烦人的方面。

开发商: PocketPal AI 是使用 React Native 构建的。找到一种平衡文本选择和保留格式(尤其是 Markdown 支持)的简单解决方案对我来说一直很棘手。如果您有这方面的经验,我很乐意听取您的意见!

变化

任务/更新 e2e 测试 2 by #541

修复方法:#543 中通过基于互助的串行化防止模型切换时的内存泄漏

任务:升级RN 0.82,llama.rn,并在#523修复

专长:在#515中将llama.rn升级至0.10.0-rc.3

变化

修复:通过 #504 将 llama.rn 更新到 0.9.2 版本

feat:重构设备检查 (GPU ...) 并在 #446 中为 OpenCL 要求添加详细消息

壮举:通过 #413 升级 llama.rn

杂务:将应用程序信息占位符图标替换为 #400

专长:在 #410 中升级 llama.rn

壮举:添加UI控制

壮举:通过 #393 升级 llama.rn

壮举:在 #381 中为 PAL 添加导入/导出

[壮举]:改进中文本地化翻译 (0715) by in #373

杂务:通过 #387 升级 llama.rn

壮举:在 #380 中同步 llama.rn -> llama.cpp以支持 LFM2

Feat: 新增思考控制

修复:useChatSession 中聊天消息重复的问题

Feat: 升级 llama.rn (因此llama.cpp) 以支持 GEMMA 3N by

壮举:通过为视觉模型添加选择退出

更新 dependencys

Feat: 改进中文本地化翻译

杂务:去掉多余的 JA: '日本語 (JA)'

Feat: 通过 IN 为 Android 添加备份和恢复支持

feat: 添加 Lookie Pal

修复(Android):阻止 app resume 时恢复

feat: 如果 content 为空,则不渲染

修复:文本生成过程中 token 缺失/重复

特点: 在中为门控模型访问添加 HF 令牌身份验证

Feat: 添加预设补全设置

feat: 添加 iPad 支持 by in #249

重构:使用 IN #250 使用基于基准测试的模型改进内存需求检查

feat: 添加 Thought 标签并同步 llama.rn by in #251

修复(iPad):新增对 Upside Down Orientation 的支持 by IN #253

修复:改进 Android 版本跨 Edge 到 Edge Display 的实现

修复:在 ChatGenerationSettingsSheet 中使用 processedSettings

修复(Android):删除 llama.rn 的 FP16 编译器标志以解决 Deepseek

下载过程需科学上网。

下载完毕以后后续可以直接使用。

图文看不懂的可以去B站搜索视频教程部署。

微灵vsoul

青丘语chatqqyai

SayloAI虚拟聊天无禁词免费

qq下载2026最新版v9.2.66 官方安卓版

qq下载2026最新版v9.2.66 官方安卓版 社交聊天 / 382.0M / 26-02-06下载

社交聊天 / 382.0M / 26-02-06下载  新浪微博Weibo手机版v16.2.2 官方最新版

新浪微博Weibo手机版v16.2.2 官方最新版 社交聊天 / 213.1M / 26-02-15下载

社交聊天 / 213.1M / 26-02-15下载  腾讯微信app8.0.69 厂商官方正版

腾讯微信app8.0.69 厂商官方正版 社交聊天 / 243.3M / 26-02-09下载

社交聊天 / 243.3M / 26-02-09下载  网易大神app4.13.0官方手机版

网易大神app4.13.0官方手机版 社交聊天 / 176.3M / 26-02-12下载

社交聊天 / 176.3M / 26-02-12下载  喵喵探案馆1.0.5手机最新版

喵喵探案馆1.0.5手机最新版 聊天社交 / 44.4M / 22-05-23下载

聊天社交 / 44.4M / 22-05-23下载  讯飞输入法下载最新版v15.0.9 官方版

讯飞输入法下载最新版v15.0.9 官方版 社交聊天 / 64.5M / 26-02-10下载

社交聊天 / 64.5M / 26-02-10下载  DeepSeek深度求索v1.7.8 手机版

DeepSeek深度求索v1.7.8 手机版 社交聊天 / 12.3M / 26-02-28下载

社交聊天 / 12.3M / 26-02-28下载  皮皮虾app最新版v6.1.0 官方正版客户端

皮皮虾app最新版v6.1.0 官方正版客户端 社交聊天 / 107.5M / 26-02-11下载

社交聊天 / 107.5M / 26-02-11下载  最右APP手机版7.2.1 安卓官方版

最右APP手机版7.2.1 安卓官方版 社交聊天 / 155.3M / 26-02-27下载

社交聊天 / 155.3M / 26-02-27下载  米游社官方版2.102.1 官方手机版

米游社官方版2.102.1 官方手机版 社交聊天 / 121.2M / 26-02-10下载

社交聊天 / 121.2M / 26-02-10下载

支持( 0 ) 盖楼(回复)

编辑回复:卡了,换个浏览器